|

INTRODUCCIÓN

Presentamos la segunda versión del tutorial Sonido 3D (La localización por el oído), (La localización del sonido) donde, además de los temas habituales,

se han añadido algunos conceptos sobre la función HRTF y sus aplicaciones, principalmente en la reproducción musical.

Sabemos que todos los parámetros implicados en la localización del sonido: variaciones de presión sonora o amplitud, tiempo y timbre pueden incluirse en

una función compleja conocida con el acrónimo HRTF, en inglés "Head Related Transfer Function" o en español "Función de transferencia de la cabeza".

En nuestro presente tecnológico, este procedimiento solamente es útil en la escucha con auriculares y siempre con las debidas reservas puesto que los

componentes subjetivos de esta tecnología hacen que no sea posible su implementación universal. También, han habido serios intentos, sin demasiado éxito

comercial, por cierto, de reproducir HRTF con altavoces y sistemas de cancelación transaural que más adelante comentaremos.

La gran cualidad de la función HRTF es que nos ayuda a comprender, en profundidad, el mecanismo de la audición, el cual, debería incluir todos los posibles

fenómenos acústicos involucrados, tal como ocurre en la propia naturaleza. Sin embargo, en la práctica, el desarrollo de esta función puede quedar limitada

por el nivel de conocimientos del proyectista y la tecnología puesta en juego, tal como ocurre en otras ramas de la tecnica. Por esta razón,

siempre hemos de tener presente que no todas las implementaciones electrónico informáticas de HRTF presentarán la misma calidad.

Todo depende del nivel de conocimiento en que nos estemos moviendo.

Por otra parte, tal como es lógico suponer, la función HRTF está íntimamente ligada con el tamaño y forma de la cabeza más pabellones auditivos

(los componentes subjetivos citados anteriormente). Esto quiere decir que, en ocasiones, el efecto tridimensional casi se esfumará, al ser la cabeza del

oyente demasiado diferente, en cuanto a medidas, del modelo patrón escogido para implementar la función HRTF.

Al respecto, hace algún tiempo invitamos a un invidente a tener una experiencia auditiva con un sistema de realidad virtual.

Incluso, nosotros mismos, muy interesados por el sonido, nos pusimos los cascos sensoriales, eso sí, con los ojos tapados. Pues bien, hay que decir que el

resultado fue decepcionante. De hecho, pudimos percatarnos que el sonido en alguno de estos sistemas es, casi siempre, un mero acompañamiento de una imagen

3D interactiva. El sonido, en sí mismo, desde el punto de vista espacial no era lo suficientemente bueno como para que un invidente (o nosotros mismos)

pudiéramos recrear en nuestra mente el espacio envolvente. Todo se reducía a una estereofonía más o menos realista aunque desprovista de los indicios

psicoacústicos que nos hacen sentir el espacio sonoro circundante como auténticamente real.

De hecho, este resultado es lo que se esperaba puesto que, en el mundo real, tal como veremos enseguida, la percepción del espacio a distancia se conforma

a través de una conjunción psíquica entre vista y oído en total sincronía. Nuestro compañero invidente, a pesar de su excelente sistema

de audición, mucho mejor desarrollado que el nuestro, dadas sus circunstancias, tampoco pudo recrear en su mente el espacio circundante tal como experimenta

habitualmente en su vida cotidiana con fuentes de sonido reales.

LA PERCEPCIÓN DE LA DIRECCIÓN

Las diversas teorías de la localización del sonido se basan en la diferencia de marcha o camino recorrido por las ondas sonoras

hasta llegar a cada uno de los oídos. Si la fuente de sonido se encuentra delante del oyente (o detrás), exactamente en el plano de simetría

de la cabeza, el camino recorrido por el frente de onda hasta encontrarse con los oídos es el mismo. Se recibe, entonces, en cada uno de ellos,

la misma información y en el mismo instante. Por lo tanto, miramos hacia adelante ( o hacia atrás) para poder evaluar con más precisión

la posición de la fuente sonora, acto guiado por el cerebro una vez realizado el análisis de la información

recibida en las áreas auditivas corticales.

recibida en las áreas auditivas corticales.

Si la fuente sonora no se encuentra exactamente delante (o detrás) del oyente, aparece una diferencia de marcha o camino recorrido proporcional

al seno del ángulo formado respecto del plano de simetría de la cabeza.

Observemos con atención la figura 1, la cual, describe la disposición de las partes implicadas en un experimento de audición donde,

el oyente, recibe señales acústicas desde una fuente sonora. El oído derecho recibe una parte de la

señal acústica radiada por la fuente sonora F. Con el izquierdo ocurre exactamente lo mismo, con la salvedad, tal como comentábamos

hace un momento, de que las trayectorias desde la fuente a cada uno de los oídos no tienen la misma longitud. Por lo tanto, en todas las

posiciones, excepto cuando la fuente sonora se encuentra delante del oyente, (o justamente detrás) aparece una diferencia de tiempo en la llegada

del frente de ondas a los oídos del oyente.

A esta diferencia de tiempo habrá que añadir una diferencia de presión sonora dependiente de la frecuencia.

La señal que llega hasta el oyente es, en casi todos los casos, una onda compleja, es decir, según Fourier, el resultado de la superposición

de muchas ondas simples provenientes del foco sonoro. Por lo tanto, en nuestro dibujo, la amplitud que llega a los oídos del oyente es una función de la

frecuencia. La parte baja del espectro se difractará muy bien alrededor de la cabeza del oyente y la amplitud de la señal en cada oído

será prácticamente la misma. No ocurrirá lo mismo con las componentes de frecuencia alta, las cuales, producirán una notable diferencia

de presiones entre sus oídos. Todo esto se traduce en que cada uno de ellos percibirá un timbre diferente según la posición de la fuente sonora

respecto del oyente.

En resumen, la dirección de donde proviene un sonido se basa en la detección, por parte del cerebro, suponiendo la no intervención de la memoria,

de las correspondientes diferencias de presión sonora y tiempo que se producen en los oídos. Si aceptamos la intervención de la memoria,

entonces, podríamos hablar de las diferencias de presión, tiempo y timbre en los oídos del oyente.

En cuanto a las diferencias de fase (Φ=K.Δr) puede demostrarse que este parámetro no juega ningún papel en la localización de la dirección de

una fuente sonora (En otros aspectos puede ser útil). Basta observar, según la ecuación anterior, que diferentes direcciones de una fuente sonora podrían producir

la misma relación de fase, según las frecuencias emitidas.

También, es interesante percatarse que otra fuente sonora simétricamente situada respecto de F producirá las mismas diferencias de presión y tiempo.

A pesar de eso, según la ley del primer frente de onda" podemos localizar, sin ambigüedad, las correspondientes direcciones de cada una

de las fuentes situadas a la izquierda o la derecha. Todo ello, nos informa que el cerebro detecta cual de los oídos recibe el primer frente de onda

procedente de la fuente para evaluar la dirección. Con lo cual, también las distintas reflexiones que se producen en locales reverberantes, parecen tomar la

dirección del primer frente. No obstante, su complemento, el "Efecto Haas" añade ciertos límites al fenómeno. Esto es, para señales de reverberación

que llegan al oído con un retardo superior a los 40 o 50 ms. aproximadamente, se producirá el fenómeno del eco.

Todo lo dicho hasta el momento nos sirve para evaluar la dirección de donde proviene un sonido en base a:

- Diferencias de presión sonora. (Efecto fisiológico).

- Diferencias de tiempo. (Efecto fisiológico).

Resumiendo, podemos expresarlo como:

Dir = f(Δp,0) + f(0,Δt)

También, si añadimos las correspondientes variaciones de timbre debido al cambio de dirección, forma de la cabeza, pabellones auditivos, etc.

la expresión queda así:

Dir = f(Δp,0,0) + f(0,Δt,0) + f(0,0,ΔT)

Donde:

Dir: Dirección de la fuente sonora.

p: Diferencias de presión sonora. (Efecto fisiológico).

t: Diferencias de tiempo. (Efecto fisiológico).

T: Diferencias de timbre. (Efecto psicofisiológico).

Finalmente, tal como se ha comentado hace un momento, es de común conocimiento que en una sala de conciertos aparece un campo acústico reverberante, el cual, "personalizará" el frente de ondas directo

que llega al oyente. Los músicos y público aficionado saben que no todas las salas de concierto suenan igual puesto que el campo reverberante más las resonancias

propias del local "colorearán" la radiación directa de la fuente.

- Ley del primer frente de onda y efecto Haas. (Efecto psicofisiológico).

Ahora, falta averiguar si es posible localizar una fuente sonora en el sentido de la profundidad en la dirección detectada. Tema que vamos a

tratar seguidamente.

LA PERCEPCIÓN DE LA PROFUNDIDAD - POSICIÓN

Acabamos de repasar los conceptos fundamentales en los cuales se basa la detección por parte del oído y cerebro de la dirección en donde se encuentra

una fuente sonora. Esto es, la diferencia de trayectoria desde la fuente a cada oído, generará las correspondientes diferencias de

presión sonora, tiempo y timbre. También, la ley del primer frente de onda, nos evita experimentar la

ambigüedad en la dirección izquierda-derecha debida a la posición de la fuente o la reverberación en los locales cerrados.

No obstante, en determinadas situaciones (percepción de la profundidad)

estos parámetros no son suficientes para entender la localización por el oído. En este apartado intentaremos aclarar esta cuestión.

Dejando de lado el sentido del olfato, es conocido que el ser humano interactúa a distancia en su medio utilizando los sentidos de la vista y el oído.

Puede decirse que estos órganos sensoriales se complementan de forma perfecta para conseguir localizar, a distancia, un cuerpo emisor de ondas en el

espacio tridimensional. La vista o el oído, considerados de forma aislada, también nos ayudan

en esta interacción con el medio pero, repetimos, "es la conjunción de la vista y el oído lo que permite al ser humano

desenvolverse e interactuar con el mundo, siempre y cuando nuestro cerebro, después del lento aprendizaje ocurrido en nuestra más

tierna infancia, pueda dirigir el funcionamiento de estos órganos de forma conjunta y ordenada." Veámoslo:

Supongamos que nos encontramos en una gran explanada. En un momento determinado se produce un ruido que nos llama la atención.

De forma casi automática, lo que hacemos es girar la cabeza hasta localizar la dirección de la fuente de sonido.

Una vez localizada, lo único que queda por hacer es detectar el origen en esa dirección. Para realizar esta acción de manera

prácticamente instantánea tenemos la visión binocular que nos informará del lugar donde se encuentra la fuente sonora, siempre

y cuando ésta sea visible.

Si, en este proceso de evaluación del origen del sonido, hubiéramos utilizado únicamente nuestros oídos, el margen de error en

la detección de la posición de la fuente, en el sentido de la profundidad, habría sido mucho mayor,

más aún para nosotros, tan acostumbrados a utilizar los sentidos de la vista y oído de forma conjunta.

Es cierto que existen determinados modos de evaluar la distancia a que se encuentra una fuente sonora pero, mientras podamos utilizar la visión,

lo seguiremos haciendo en detrimento de la apreciación de distancias por el sonido. Otra cosa sería padecer una ceguera total, pues,

sólo en este caso, las propiedades de localización por el oído alcanzarían su máximo rendimiento.

Prestemos atención, ahora, a la figura, 2 donde observamos a un oyente O y tres fuentes sonoras, F1, F1' y F2,

las cuales, al estar suficientemente alejadas del oyente supondremos la llegada de ondas planas.

La diferencia de tiempo t1, junto con las correspondientes diferencias de presión sonora y timbre permitirán determinar

en que dirección se encuentra la fuente sonora F1. Ahora bien, observemos que la fuente F1' situada en la misma dirección

producirá igual diferencias de tiempo, presión y timbre.

La fuente F2 producirá la diferencia de tiempo t2. En nuestro caso se cumple que t1 = t2 puesto que, en este ensayo

hemos escogido una posición posterior en las que las distancias existentes desde la fuente F2 a los oídos del oyente es

idéntica a las distancias entre la fuente F1 y dicho oyente.

Seguidamente, observemos el siguiente hecho. Si, elevamos las fuentes sonoras manteniendo sus distancias relativas respecto de la cabeza del oyente,

las diferencias de tiempo y presión sonora seguirán siendo prácticamente las mismas. El timbre, en cambio, debido a los pabellones auditivos principalmente,

empezará a sufrir variaciones en función de la altura de la fuente. Con estos indicios, el cerebro puede llegar a detectar la posición arriba-abajo de

una fuente sonora.

Existen en el proceso de audición una variación de parámetros que nos ayudarán a determinar la posición de una fuente sonora:

VARIACIÓN DE PARÁMETROS

- La evaluación de la sonoridad en función de la distancia existente entre fuente y oyente. Hemos de decir que la apreciación

de distancias en base a la sonoridad es francamente muy pobre. Factores tales como la reverberación o los cambios de volumen de la fuente en el

origen enmascararán las apreciaciones. No obstante, la variación de la sonoridad es un truco muy utilizado en las técnicas de

grabación multipista para dar la sensación al oyente que determinados instrumentos se encuentran más alejados y, por esta

razón, su sonoridad es menor. Representa un indicio aproximado para localizar a la fuente sonora en el sentido de la profundidad. (Eje Z).

-

En grandes recintos, salas de concierto, teatros, etc. La relación sonido directo/reflejado también puede ayudarnos a evaluar si

la fuente sonora se encuentra cerca o lejos del oyente. No sirve para determinar una posición concreta. Este efecto es muy utilizado,

también, en los estudios de grabación.

- El efecto Knudsen, es decir, el cambio de timbre por absorción de las frecuencias altas por el aire nos informará de la

lejanía o cercanía de la fuente, pero no de su localización precisa. Además, es necesario conocer previamente el sonido,

esto equivale a decir que la intervención de la memoria es esencial. Un buen técnico de grabación utilizará este efecto

junto con los dos anteriores para dar sensación de lejanía a determinados instrumentos.

- La relación presión/velocidad de las partículas.

Si nos encontramos en el campo cercano de la fuente, es decir, en aquel lugar donde la radiación acústica se describe como

una onda esférica, es posible, según Von Békésy, determinar la distancia mediante dicha relación, la cual, se traduce en

nuestra psico-fisiología en un cambio de timbre variable según la distancia fuente-oyente. Su efecto está limitado a distancias muy cercanas a la fuente.

(Hasta 1,5m. aprox.)

- El análisis del timbre, junto con los parámetros anteriores, nos ayudará a resolver, las ambigüedades "delante/detrás" arriba/abajo.

Para ello, tenemos a nuestra disposición:

- El efecto de "sombra" de los pabellones auditivos, los cuales, nos ayudan a evaluar si el sonido proviene de delante o detrás del oyente, incluso

arriba o abajo respecto del sistema de audición.

- Los movimientos de la cabeza en animales y humanos potenciarán, y mucho, el efecto anterior. Para confirmar este aserto, podemos realizar el

siguiente experimento. En una habitación con

algún tipo de fuente sonora, colocamos una cabeza artificial desprovista de los pabellones auditivos. Seguidamente, instalamos un sistema de

seguimiento, el cual, permitirá a ésta moverse como cualquier cabeza humana (izquierda-derecha y arriba-abajo)

Acto seguido, introducimos en otra sala a un oyente provisto de auriculares y el sistema impulsor de los movimientos de la cabeza artificial.

Entonces, ocurre lo siguiente: mientras el sistema de seguimiento se encuentre desconectado, al oyente le será difícil averiguar si la

fuente sonora se encuentra delante o detrás. Incluso arriba o abajo.

Todo lo contrario ocurre cuando conectamos el dispositivo de seguimiento. En estas condiciones, el oyente, gracias a los movimientos de su cabeza,

seguidos con precisión por la cabeza artificial, podrá detectar la posición de la fuente sonora, llegando, incluso a averiguar

si se encuentra en la parte anterior o posterior.

- El conocimiento que tengamos sobre un sonido también nos ayudará a situar correctamente a la fuente sonora en el espacio.

Por ejemplo, si oímos el ruido producido por un avión, las diferencias de tiempos y presión sonora, nos informarán de la

dirección donde se encuentra el origen del sonido pero si identificamos el tipo de ruido, habrá una tendencia clara a levantar la cabeza

y mirar al cielo en la citada dirección. Claro que también puede suceder que el avión puede estar en tierra momentos antes del

despegue. Es, entonces, cuando el sentido de la vista entra en acción para eliminar toda duda sobre su posición.

- La visión es el punto final en la determinación de la posición de una fuente sonora. Ésta nos dará,

después de las sucesivas evaluaciones de la dirección realizada por el sistema auditivo, la ubicación exacta de la fuente de sonidos.

Si la visión no existe, la tolerancia en la apreciación de la posición será mucho mayor.

Al ser la percepción a distancia del entorno una conjunción de propiedades psico-fisiológicas, extendiendo su dominio, en la gran mayoría

de personas, a los sentidos de la vista y el oído, es realmente difícil la percepción auténticamente tridimensional del sonido

en los sistemas de reproducción acústica. No obstante, con los sistemas de Realidad Virtual, al trabajar conjuntamente

con sonido e imagen más interactividad, es posible recrear espectaculares espacios visuales y sonoros de gran efectividad.

Lamentablemente en la mayoría de sistemas RV, el sonido, en cuanto a prestaciones espaciales, no se encuentra a la altura de la imagen, tal como

hemos comentado al principio de este documento.

|

Con este tipo de experimentos, en los que De Boer, en los años cuarenta del siglo pasado fue pionero, llegamos a la conclusión de que los

movimientos de la cabeza, unidos a la asimetría arriba-abajo de ésta más la forma de los pabellones auditivos, son cruciales para

averiguar la dirección/posición de la fuente sonora, sobre todo en lo que respecta a las correlaciones delante-detrás y arriba-abajo.

|

SÍNTESIS

En resumidas cuentas, tal como acabamos de leer, los mecanismos que tiene nuestro cerebro para localizar y situar una

fuente sonora en el espacio real o virtual utilizando dos oídos sanos son:

Determinación de la dirección:

- Diferencias de tiempo. (Efecto fisiológico).

- Diferencias de presión sonora. (Efecto fisiológico).

- Diferencias de timbre. (Efecto psico-fisiológico).

Determinación de la posición:

- Movimientos de la cabeza. (Ver más adelante "La interactividad")

- Relación sonido directo/reflejado.

- Efecto Knudsen.

- Evaluación de la sonoridad.

- Teoría de Von Békésy.

- Conocimiento sobre el sonido percibido.

Finalmente, en locales cerrados, podemos añadir:

- Ley del primer frente de onda y Efecto Haas. (Efecto psico-fisiológico).

DESARROLLOS TECNOLÓGICOS

Como es de común conocimiento, los desarrollos tecnológicos aparecen en el momento en que se desea reproducir los fenómenos físicos involucrados,

en nuestro caso, la audición. Diversos procedimientos existen para convertir una teoría en un hecho real:

- Si implementamos de forma práctica únicamente el primer término de la ecuación vista anteriormente, es decir: Dir = f(Δp) estaremos ante

la reproducción estereofónica de intensidad o standard que todos conocemos.

- Si hacemos lo mismo con el primer y segundo término conjuntamente, Dir = f(Δp,0) + f(0,Δt) nos moveremos en el campo de la

estereofonía avanzada.

- Finalmente, si implementamos la ecuación completa, Dir = f(Δp,0,0) + f(0,Δt,0) + f(0,0,ΔT) lo que hacemos es poner en

práctica lo que conocemos como la función HRTF.

Veamos estos procesos más detalladamente.

La estereofonía experimental de De Boer y Fletcher

Estos científicos desarrollaron, de forma independiente, allá por los años cuarenta del siglo pasado, dos alternativas diferentes para la reproducción

estereofónica. El primero desarrolló la estereofonía utilizando una cabeza artificial. El segundo, experimentó con un sistema electroacústico compuesto

de tres micrófonos y tres altavoces. Por razones prácticas, su sistema quedó, finalmente, compuesto de dos micrófonos y dos altavoces. Los resultados

fueron muy positivos en ambos sistemas.

Con la cabeza artificial de De Boer se realizaron grabaciones en donde se ponía en práctica la ecuación: Dir = f(Δp,0) + f(0,Δt). Es decir,

con este sistema quedaban registrados la variaciones de presión sonora y tiempo de llegada en cada oído, tal como sucede, también, en nuestro sistema

auditivo.

Con el sistema de Fletcher, utilizando dos micrófonos convenientemente separados se intentaba poner en práctica la misma ecuación.

En sus experimentos, ambos se percataron de que las variaciones de presión sonora y tiempo de llegada, eran equivalentes, pues se

obtenían los mismos resultados, tanto si se utilizaban las variaciones de tiempo, las variaciones de presión o ambas conjuntamente.

Fue significativo descubrir que una posición virtual de la imagen sonora situada, por ejemplo, en el centro-izquierda provocada por las variaciones de

presión sonora, podía ser neutralizada utilizando las diferencias de tiempo existentes para esa posición pero en sentido contrario, con lo cual,

la imagen volvía a situarse en el origen.

La estereofonía standard

Finalmente, por razones de economía, la estereofonía utilizó y aún utiliza, casi de forma exclusiva, las diferencias de presión sonora en los oídos

consiguiéndose grabaciones musicales de excelente calidad. Actualmente, las mesas de mezcla funcionan según este principio; control panorámico

individual por canal, lo cual, equivalente a producir variaciones de amplitud en el canal izquierdo o derecho para situar a la fuente sonora en un punto

escogido entre los altavoces. Ahora, la ecuación puesta en práctica es: Dir = f(Δp). Esto es, La dirección de las fuentes sonoras, repetimos,

son detectadas por el oyente utilizando únicamente diferencias de presión sonora.

En la estereofonía avanzada, existen diversas técnicas de registro que incorporan, además, las diferencias de tiempo, las cuales, nos permiten abrir,

aún más, el campo sonoro. Por ejemplo, la utilización de una cabeza artificial u otros métodos equivalentes.

De la estereofonía, nació la cuadrifonía gracias a los trabajos de David Hafler de la empresa Dinaco y, partiendo de esta tecnología, la empresa

Dolby desarrolló su sistema Surround.

Entonces, surge la pregunta: ¿Para qué complicarse la vida con HRTF y demás ensayos avanzados si, actualmente, ya tenemos sistemas de audio muy efectivos?

La respuesta la tenemos observando la fig.3. Mientras que en la estereofonía convencional las fuentes aparecen, en principio, en un espacio virtual de una dimensión,

es decir, en la línea que une los dos altavoces según la fig.3a, con la función HRTF y otras técnicas avanzadas lo que se pretende es que el oyente

se encuentre inmerso en el mismo campo sonoro con atributos de "realidad", fig.3b.

Por otra parte, la experimentación HRTF nos permite conocer mucho mejor el comportamiento del oído en lo que respecta a la localización de las fuentes

de sonido.

Entre la estereofonía clásica y las técnicas de vanguardia se encuentra el sistema Dolby Surround de la fig.4, el cual, nos permite disfrutar,

tanto en nuestros hogares como, también, en las salas de cine, de un sonido envolvente de calidad.

La función HRTF

LA CABEZA HUMANA NATURAL Y ARTIFICIAL

En el desarrollo de aplicaciones acústicas avanzadas, la cabeza humana es un elemento imprescindible para la realización de medidas e implementación de HRTF.

Las magnitudes físicas asociadas a los parámetros vistos hasta el momento están condicionados por la forma y tamaño de la cabeza. Todo lo cual no deja de ser

un inconveniente. Por lo tanto, para la realización de las medidas acústicas y grabaciones musicales es aconsejable realizarlas en base a una cabeza humana

de tipo medio, la cual, nos servirá para proyectar un modelo sintético o una implementación software con las mismas propiedades acústicas que el modelo

de referencia.

Como la función HRTF está condicionada por la fisonomía de la cabeza, todas las personas que se salgan del marco establecido, en cuanto a las medidas seleccionadas,

tendrán más dificultades para experimentar la música en 3D realizada con la implementación HRTF y/o cabeza artificial.

Dejando a un lado la calidad de los micrófonos utilizados en la cabeza artificial, los cuales, tendrían que situarse en el mismo nivel de comportamiento

que el sistema de audición oído-cerebro, (actualmente es prácticamente imposible), las propiedades fisico-acústicas de "superficie" de la cabeza artificial

son, básicamente, las mismas en el original (cabeza humana) y la copia (cabeza artificial).

LAS CURVAS DE SIVIAN Y WHITE

Ralizadas a mediados de los años cuarenta del siglo XX, representan un primer indicio del comportamiento, tanto de una cabeza humana natural

como, también, de un modelo sintétíco y nos sirven para extraer importantes conclusiones relacionadas, en este caso, con la amplitud de la onda y el timbre,

demostrando que el oído izquierdo no recibe la misma presión sonora que el derecho (excepto en frecuencias muy bajas o cuando la fuente de

sonido se encuentra justamente en el plano de simetría de la cabeza. Estas curvas podemos considerarlas como el primer paso en la creación de la

función HRTF actual.

Este comportamiento, reflejado en las curvas presentadas, son una función de la frecuencia y la posición, por lo tanto, dado que las señales musicales o

la palabra son ondas mecánicas complejas, a medida que la fuente se mueve alredededor de la cabeza cambia el timbre percibido. También, sucede lo mismo

cuando dicha fuente se mueve de arriba a abajo o viceversa. Las variaciones de amplitud (presión sonora), timbre y, finalmente, tiempo de llegada son, pues,

los parámetros que una función HRTF completa debería recoger en sus algoritmos.

En síntesis, para localizar la dirección de procedencia de un sonido, podemos hacerlo en base a las diferencias de presión sonora,

a las diferencias de tiempo o ambas conjuntamente. También, las diferencias de timbre detectadas por el cerebro afianzarán, aún más, las percepciones

anteriores.

Finalmente, añadiendo la interactividad (en un futuro próximo), conseguiremos emular, prácticamente de forma completa, el comportamiento del oído en

cuanto a la percepción del espacio sonoro, aunque este caso, tal como puede comprenderse, es el más complejo desde el punto de vista de

la implementación tecnológica.

LA INTERACTIVIDAD EN EL SISTEMA

Supongamos que, en una sala de audición con un tiempo de reverberación reducido, situamos una esfera maciza del tamaño aproximado al de una cabeza humana

normal, a la cual, se añaden dos micrófonos diametralmente opuestos. Necesitaremos, también, un pequeño altavoz o "baffle" que pueda trasladarse

alrededor de nuestra cabeza. De esta manera, intentamos emular el comportamiento de nuestro sistema de audición.

En otra habitación contigua se situa un oyente con auriculares. (De Boer, en los años cuarenta, (siglo XX) fue el primer científico en realizar

este experimento.)

Esta primera fase de la experiencia fue todo un éxito pues el oyente podía seguir el desplazamiento del altavoz a través del sonido percibido.

En estas condiciones, situando el altavoz en cualquier posición, desde la zona izquierda a la derecha, se podía localizar su posición sin esfuerzo alguno

tal como sucede en el mundo real.

En la segunda fase del experimento empezaron los problemas; en este caso, se trataba de averiguar si el oyente, recordemos, provisto de auriculares y

situado en la habitación contigua era capaz de discriminar entre las posiciones frontal o posterior. Para ello, la fuente sonora se colocaba, ahora,

justamente delante o detrás de la cabeza artificial. Lamentablemente, esta fase del experimento fue un fracaso. Aunque, en ocasiones, se acertaba en

la ubicación de la fuente sonora, en la mayoría de pruebas realizadas era imposible saber con total seguridad si la fuente sonora se encontraba

delante o detrás del oyente. Más bien parecía un acertijo que una percepción real y auténtica.

En la tercera fase del experimento, De Boer tuvo una intuición genial, añadir movimiento, en absoluta sincronía entre la cabeza artificial,

la cual, recogía el sonido, y la cabeza real receptora a través de auriculares. De esta manera, si el movimiento de la cabeza artificial, moviéndose

sobre su eje desde el lado izquierdo al derecho y viceversa a modo de negación, era seguida por el oyente en total sincronia, la discriminación delante-detrás

fue totalmente posible. Ahora, mediante el movimiento, podía saberse, si la fuente sonora se encontraba delante o detrás del oyente, sin ambiguedad alguna.

Hasta aquí llegó el experimento de De Boer.

Para llegar a la cuarta fase del experimento, realizado por otros científicos, tenemos que dirigirnos hacia los años setenta del siglo pasado

hasta llegar a nuestro presente tecnológico. Sabemos que los micrófonos de los años cuarenta, en cuanto a prestaciones y tamaño no eran

iguales a los modelos que estamos acostumbrados a utilizar en el presente. Por otra parte, en aquella lejana época se despreciaba el efecto que podría tener

el pabellon auditivo y perfil general de la cabeza, incluso torso, sobre la percepción de la dirección.

En el presente, en vez de utilizar una simple cabeza artificial, una esfera con un micrófono a cada lado, empiezan a utilizarse cabezas artificiales de tamaño medio

con todas y cada una de las características que definen a una cabeza humana en todos sus detalles. También, entran en escena diminutos micrófonos

de excelente calidad, en especial en lo que respecta a la respuesta en las frecuencias más altas del espectro.

En estas condiciones, los resultados, en cuanto a la percepción de la dirección mejoraron ostensiblemente aunque al no existir interacción,

la discriminación delante-detrás, incluso arriba abajo, seguía siendo un tanto ambigua. (y lo sigue siendo en bastantes ocasiones).

Posteriormente, en la investigación y recogida de muestras de sonido empezó a sustituirse la cabeza artificial por otra natural, insertando los

micrófonos en los mismos canales auditivos de algún voluntario.

Del estudio y procesado de las muestras recogidas con la adecuada tecnología electrónico informática, llegamos a lo que hoy se conoce como la función

HRTF aplicable a cualquier fuente de sonido.

VOLVIENDO A LA INTERACTIVIDAD DE "DE BOER"

Ahora nos preguntamos ¿A qué es debido que De Boer necesitara del movimiento en sincronía entre cabeza artificial y oyente para lograr una

descriminación real entre las posiciones delante-detrás?

En primer lugar, ahora sabemos que existe una fuerte correlación entre la dirección del sonido que percibimos y la composición de la señal que llega al

sistema de audición; a cada posible dirección de la fuente de sonido detectado por el cerebro, le corresponde un patrón de ondas determinado, es decir,

una combinación diferente en cuanto a amplitudes, tiempos y timbres.

Es evidente que, si en la escucha de una fuente sonora determinada, la posición del oyente varía en el tiempo, el cerebro de éste recibirá diversos patrones de percepción, (no uno exclusivamente),

todos ellos diferentes, aunque apuntando en la misma dirección/posición. De esta manera, afianzamos, aún más las percepciones de la fuente de sonido.

En resumen, si la posición entre la fuente y el oyente es invariable, únicamente existirá un patrón determinado para evaluar la dirección/posición de la fuente,

mientras que si el oyente se mueve, el cerebro recibirá diversos estímulos, todos ellos diferentes, pero equivalentes en cuanto a la dirección

de la fuente de sonido.

La importancia de los movimientos del observador para una mejor detección del origen de un sonido podemos observarla en el mundo animal, ya sea a través

del movimiento de la cabeza, o bien, de sus pabellones auditivos móviles.

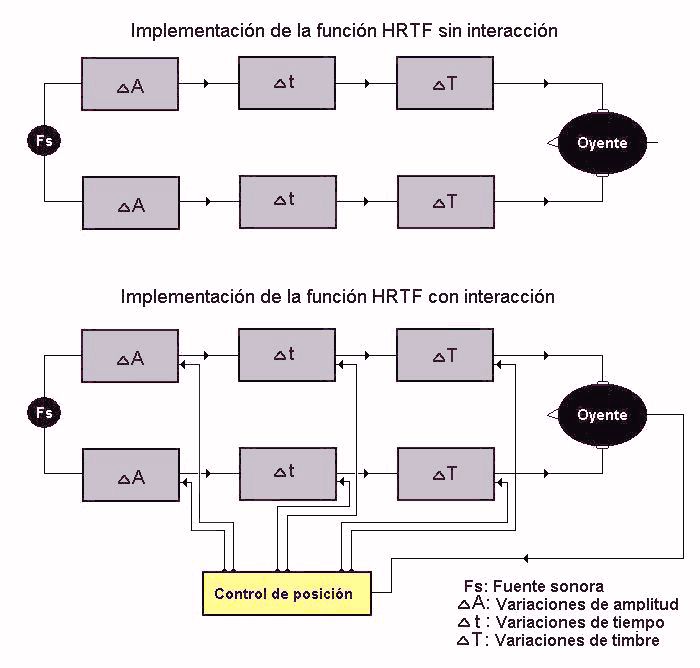

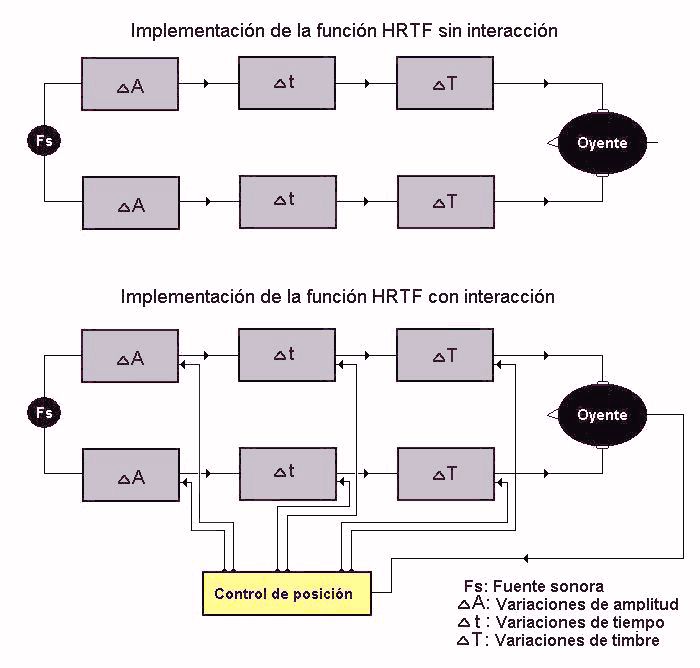

Tenemos, pues, dos maneras diferentes de implementar la función HRTF.

En la primera opción, la actual, el oyente permanece en una posición fija, pues aún cambiando de posición, al no existir la interactividad, el campo sonoro

percibido sigue siendo el mismo y, aún cuando los resultados pueden ser óptimos, en ocasiones, el efecto tridimensional se esfumará debido a todo lo

expuesto en este documento.

En la segunda opción, la futura, la interactividad afianzará, y mucho, las percepciones en cuanto a direcciones/posiciones puesto que en esta situación,

a cada posición del oyente, le corresponderá un patrón diferente en cuanto a amplitudes, tiempos y timbres, tal como sucede en la vida real con los

humanos y otros muchos animales.

Como ya se ha comentado anteriormente, un procesamiento completo de las señales para realidad virtual o sonido HI-END debería dar cuenta,

de estas variables:

|

Dir(p,t,T) = Dir(Δp,0,0) + Dir(0,Δt,0) + Dir(0,0,ΔT).

|

Dicho procesamiento es lo que conocemos como HRTF, "Head related transfer function" o, en castellano, "Función de transferencia

de la cabeza". Aunque, en el presente, sin la deseada interacción.

OPCIONES EN EL PROCESO DE GRABACIÓN HRTF

En primer lugar, podemos utilizar el sistema más simple, "la cabeza artificial". Con ella, tenemos la facultad de utilizar todos los parámetros puestos en

juego por la Naturaleza sin grandes complicaciones tecnológicas. Eso sí, en una sóla posición, puesto que la interacción con el oyente no existe, lo cual,

limitará las percepciones con atributos de realidad.

También, podemos utilizar algún sistema informático con implementación de HRTF (sin interacción actualmente) y, aunque su utilización

es relativamente simple, no lo es, sin embargo, el trabajo previo de creación del programa informático, el cual, puede llegar a ser bastante complejo.

Finalmente, tengamos presente que, aunque la cabeza artificial percibe, en principio, lo mismo que nosotros si está bien diseñada, hay una importante

diferencia entre usar dicha cabeza o un programa informático con implementación de HRTF; con la cabeza artificial el trabajo está hecho, en el sentido

de crear o experimentar entornos sonoros originales. Todo lo contrario ocurre con la implementación de HRTF en un programa informático, puesto que, de esta manera,

ponemos en manos del ingeniero de sonido, músico, productor, etc. otro medio más para poner en marcha la creatividad, no solamente con la música sino,

también, con el mismo espacio sonoro si el "plugin" HRTF está bien concebido.

Alternativas de escucha

LA AUDICIÓN CON ALTAVOCES

Supongamos, ahora, que al oyente "O1", situado en la sala de conciertos, le colocamos un minúsculo micrófono en cada oído o,

mejor aún, lo sustituimos por una cabeza artificial.

A continuación, según la parte inferior del dibujo, enviamos las señales I y D recogidas a los amplificadores

a1 y a2, los cuales, a su vez, enviarán las señales a sus respectivas pantallas acústicas situadas en una sala de

audición.

La experiencia nos dice que el oyente O2 situado en la sala de audición no obtiene la misma impresión de espacio sonoro que

el oyente O1 situado en la sala de conciertos. Basta observar que el oído izquierdo de O2 no solamente recibe

la señal del oído izquierdo de O1 sino, también, una componente de diafonía d

procedente de la pantalla acústica derecha.

Lo mismo podemos decir del oído derecho, el cual, además de la señal que le es propia, recibe la componente de diafonía

i procedente de la pantalla situada a su izquierda. Este grave defecto del sistema estereofónico convencional,

hace imposible recrear un espacio sonoro idéntico al que se produce en la sala de conciertos.

También, existe un campo sonoro reverberante r originado en la sala de audición que modificará el campo directo y reverberante

original de la sala de conciertos.

Reducir el campo reverberante en la sala de audición no es difícil. En cambio, la eliminación de las señales de diafonía

i y d es realmente un problema complicado que requiere la manipulación

algebraica del sonido procedente de la sala de conciertos.

Mientras que algunos investigadores han creado teorías y implementaciones más o menos complejas para eliminar esta diafonía. Otros, en cambio, dudan

si realmente este procedimiento es el correcto. Basta observar que la cancelación transaural será eficaz siempre y cuando la reverberación de la sala

tienda a cero y el oyente se situe justo enfrente de los altavaces, simétricamente situado, tal como podemos ver en la figura 5. Todo lo cual, representa un serio

engorro utilizar este método de reproducción en una sala de estar común y corriente.

Sin embargo, la audición con altavoces, incluso con una simple grabación estereofónica, puede llegar a ofrecer una gran calidad si el proceso de grabación

cumple con todos y cada uno de los requisitos involucrados.

LA AUDICIÓN CON AURICULARES

Es obvio que la audición con auriculares eliminaría la diafonía entre los dos canales, puesto que la señales de los

oídos izquierdo y derecho del oyente O1 en la sala de conciertos, llegarían a los respectivos oídos del oyente O2 en

la sala de audición. En este sentido, la diafonía habría sido eliminada por completo.

No obstante, recordando algunos conceptos vistos anteriormente, aparece un serio inconveniente que también impedirá la recepción de un campo sonoro espacial completo.

Supongamos que realizamos nuevamente el experimento anterior pero, en este caso, sustituimos las pantallas acústicas por unos auriculares.

Se comprende que si O1 se mueve o gira la cabeza, las diferencias de tiempo, presión sonora y timbre recogidas

corresponderán a su nueva posición. Es decir, a cada posición del oyente (o de la fuente sonora) se creará tal como ya sabemos, un

patrón determinado en cuanto a la información recogida (diferencias de tiempos, presión sonora y timbre) y, gracias a esta

información, el cerebro situará a la fuente sonora en la adecuada dirección.

Evidentemente, no ocurre lo mismo con el oyente de la sala de audición,

el cual, recordemos, en este momento está utilizando auriculares. Si, en cualquier momento, gira la cabeza hacia un lado, el campo sonoro

percibido también se moverá hacia ese lado puesto que él es el portador de los elementos de transducción electroacústicos

(auriculares). En estas condiciones, la información recibida seguirá siendo la misma, independientemente de los cambios de posición del oyente.

Nos encontramos, pues, ante una experiencia inusual para el cerebro, puesto que en el mundo real, tal como le sucede al oyente en la sala de conciertos,

a cada posición tendría que recibir un patrón determinado de información tal como hemos visto más arriba.

Ante esta situación, el sonido deja de percibirse como un campo espacial en lo que respecta, sobre todo, a la descriminación de las señales

delante-detrás.

Por fortuna, parece ser que el cerebro, en el campo de actuación que estamos tratando, tiene varias formas para realizar el mismo cometido. Por ejemplo,

prestemos atención a la estereofonía clásica, la cual, representa, en principio, un campo sonoro unidimensional de izquierda a derecha. Para lograr un buen ambiente

estereofónico, tanto podemos jugar con las variaciones de amplitud o de tiempo indistintamente. Aunque, si utilizamos los dos parámetros de forma conjunta, afianzaremos, aún más,

las diferentes posiciones de los instrumentos implicados, reduciendo la ambigúedad en la posición. No obstante, en la práctica utilizamos las

variaciones de amplitud en, prácticamente, todos los casos.

Lo mismo sucede con la descriminación de señales delante-detrás. Podemos utilizar las variaciones de timbre, incluso de tiempo producidas por los

pabellones auditivos o la interactividad, o bien, ambos fenómenos conjuntamente, con lo cual, las descriminaciones arriba-abajo o delante-detrás se

producirían mucho más claramente.

SÍNTESIS

En definitiva, las alternativas que tenemos a nuestra disposición en la reproducción del sonido son:

- Reproducción monofónica

Sin efectos indicadores de dirección.

- Reproducción estereofónica con altavoces.

Aquí aceptamos la diafonía acústica como un mal menor dada la simplicidad que reporta este sistema. Con modernas técnicas de

grabación pueden lograrse excelentes resultados.

-

Reproducción estereofónica con auriculares.

En este caso, pueden obtenerse reproducciones sonoras con una total independencia de los dos canales. Al respecto, a mediados del siglo XX se popularizaron

grabaciones de gran calidad realizadas con cabeza artificial inmóvil.

Es posible, también, crear entornos virtuales sonoros en los cuales, la posición de las fuentes sonoras sean independientes de los

movimientos del oyente gracias a la implantación del proceso HRTF junto con los apropiados dispositivos de seguimiento situados en los auriculares

del oyente, tal como hemos visto.

- Reproducción cuadrafónica.

Aquí se añaden, al sistema estéreo convencional, dos o más canales

laterales o posteriores para dar cuenta de los efectos reverberantes de la sala de conciertos o incluir efectos especiales envolventes. También es

posible recrear imaginativos espacios sonoros.

- Sistemas electroacústicos en los que se elimina la diafonía de la sala de audición

A pesar de su difícil puesta a punto,

pueden conseguirse reproducciones sonoras de gran impacto y efectividad desde el punto de vista espacial, dando lugar a

compactos equipos de reproducción con una o dos dos pantallas acústicas.

Estos sistemas son muy útiles, incluso para entornos virtuales. En este sentido, el usuario se coloca un ligero y cómodo casco sensorial

con el sistema de visualización y seguimiento. El sonido, en este caso concreto, proviene de altavoces convenientemente situados.

REALIDAD VIRTUAL

Una vez descritas las bases en que se apoyan la estereofonía y cuadrafonía, estamos preparados para describir los dispositivos

electroacústicos asociados con los equipos de Realidad Virtual. El primer paso, tal como hemos hecho en alguna otra ocasion, será definir,

lo más claramente posible, el término Realidad Virtual.

Desde mediados de la decada de los 40, los investigadores empiezan a experimentar e interactuar con los primeros ordenadores de muy diversas maneras.

En los primeros tiempos, dicha interacción venía dada, en el sentido hombre-máquina por la combinación lógica de

diversas conexiones realizadas en una especie de panel de control o utilizando teclados primitivos.

Las respuestas de la máquina se interpretaban a través de combinaciones luminosas, dispositivos electromecánicos, etc. Eran,

sin ningún lugar a dudas, toscos sistemas de comunicación.

La aparición de la pantalla de rayos catódicos significó un paso de gigante en la comunicación entre la máquina y el

hombre. Con el tiempo, los interfaces fueron perfeccionándose hasta llegar a los modernos teclados, pantallas y demás accesorios de

comunicación de la actualidad. Si a este significativo desarrollo del hardware añadimos el ocurrido de forma paralela en el software

obtenemos, finalmente, los modernos ordenadores multimedia de la actualidad con sistemas operativos gráficos relativamente fáciles de

utilizar.

Hoy en día, la información que procesamos con los ordenadores puede estar compuesta de textos, imagen, vídeo, sonido y música.

Sin embargo, en líneas generales, la transferencia de información es aún un proceso artificial que se aparta bastante de los

clásicos esquemas de la comunicación que, por propia naturaleza, el ser humano ha desarrollado en su lenta pero

inexorable evolución. Esto es, la comunicación directa, frente a frente, utilizando canales de transmisión-recepción naturales

de gran anchura de banda, donde los datos enviados o recibidos fluyen con extrema facilidad.

Estos canales de comunicación son, en este caso dos: el aire que transporta las variaciones de presión sonora y la luz, portadora de

las imágenes que podemos ver.

Si añadimos el tacto como un medio más de transferencia de información, la cantidad total de datos que pueden transmitirse por segundo

entre dos seres humanos interactuando directamente es muy elevada.

La idea, entonces, es esta: ¿Por qué no comunicarse con los sistemas informáticos utilizando los esquemas clásicos de la

comunicación?

La propuesta es realmente fascinante, pues el ordenador y el ser humano se reencontrarían en un nuevo entorno diseñado especificamente para

interactuar con gran eficacia. Además, también facilitaría el trabajo de los usuarios que podrían actuar de forma mucho

más natural e intuitiva, tal como hacemos en el mundo real.

Es cierto que esta nueva manera de enfocar " la relación hombre máquina" va a generar una gran cantidad de problemas técnicos,

en especial los relacionados con la anchura de banda del canal de comunicación, velocidad e interactividad. No obstante, en el futuro,

estos escollos desaparecerán, tal como ha pasado en otras ramas de la tecnología. Será, entonces, cuando dispondremos de un

auténtico universo alternativo para trabajar o pasar nuestros momentos de ocio, ofreciéndonos espacios a nuestra medida

para la música, la cultura, la ciencia, el teatro y el cine.

Como esta sección está dedicada al sonido, enfocaremos la tecnología virtual desde este punto de vista, sin olvidar la estrecha

relación existente con el sentido de la vista. De hecho, cuando se habla de Realidad Virtual, nos imaginamos a un usuario interactuando con la

visión en un mundo tridimensional. En cuanto al sonido, es cierto que es muy importante, pero generalmente no se le presta la debida

atención.

Tal como comentamos en otra ocasión, nosotros podemos asegurar que el sonido, como principal portador de la emoción y sentimiento de una

imagen, es el toque final para conseguir un mundo virtual de elevado realismo. Ahora bien, para que la escena observada sea creible espacialmente es

deseable que exista una estrecha correlación entre la imagen y el sonido y, además, la interactividad ha de permitir que, a pesar de los

movimientos del usuario, el espacio virtual permanezca estable

Por ejemplo, imagínate que te has introducido en un entorno virtual. En un momento determinado cierras los ojos. ¿Qué pasa entonces?

Si realizas la misma acción en el mundo real, los estímulos acústicos te ayudarán a mantener la imagen mental de la escena que

tan sólo hace un momento estabas observando. ¿Ocurre lo mismo en un entorno virtual? La verdad es que en la mayoría de máquinas

bautizadas con este nombre el sonido es un mero acompañante y la asociación

con la imagen observada es, en muchas ocasiones, muy simple. Si, por ejemplo, aparece una moto por el lado izquierdo, es cierto

que el tubo de escape sonará por el auricular izquierdo, pero la similitud con el mundo real acaba aquí. La espacialidad sonora, esto es,

la sensación de profundidad no existe, pues la imagen de la moto puede aparecer a una distancia virtual de cinco metros pero el sonido del tubo de

escape lo tienes dentro de la cabeza. Es decir, la correlación audio-visual no es, ni mucho menos, perfecta. No obstante, aunque dicha correlación

no sea la óptima, el cerebro del oyente intentará situar a la fuente sonora en el lugar correcto de la imagen... y la mayoría de veces lo consigue.

Finalmente, la estabilidad espacial, esto es, la capacidad del sonido y la imagen de permanecer estáticos a pesar de los movimientos del observador

es una cualidad fundamental que han de poseer los entornos virtuales de calidad.

En resumen, veamos rapidamente, los requisitos indispensables de un sistema acústico para Realidad Virtual.

Correlación entre sonido e imagen

Si el observador permanece inmóvil y es el objeto de la escena virtual el que se mueve de derecha a izquierda o viceversa, el sonido deberá

parecer que se mueve con él en el mismo sentido.

Si el desplazamiento ocurre en el sentido de la profundidad o arriba y abajo, diversos mecanismos de actuación sobre los canales sonoros deben de

hacernos creer que el sonido sigue a la imagen.

Estabilidad espacial

El campo sonoro, al igual que la imagen, a de permanecer estable en el espacio virtual independientemente de los movimientos del observador.

Lo ideal sería conseguir los seis grados de libertad en el movimiento de éste:

- Movimiento delante/atrás.

- Moviento hacia la izquierda y/o derecha.

- Movimiento hacia arriba o abajo.

- Función rotatoria lateral.

- Función rotatoria vertical.

- Función rotatoria horizontal.

En la práctica, escogeremos los grados de libertad en función del tipo de entorno virtual. Por ejemplo, si el observador se encuentra

sentado, cosa por otra parte bastante común, escogeremos como imprescindibles:

- Función semi-rotatoria vertical.

- Función semi-rotatoria horizontal.

De esta manera, el observador podrá mover la cabeza mirando hacia arriba, abajo, izquierda y derecha mientras que el entorno visual y

acústico mantiene su estabilidad espacial.

Digamos, finalmente, que para conseguir la estabilidad espacial de la escena, junto con los sistemas de visualización, audición y

tactiles, es necesario incorporar un dispositivo de seguimiento/orientación para que el ordenador "pueda conocer" en todo momento la

posición en que se encuentra el observador y actuar en consecuencia con la imagen, el sonido y el tacto. Es decir, la interactividad entre

el usuario y el ordenador ha de ser muy alta.

NOTA FINAL

A pesar de que, en lo que respecta al fenómeno de la localización por el oído, hemos puesto cierto énfasis en el

fenómeno de las diferencias de tiempo, los sistemas electroacústicos utilizados en los procesos de grabación/reproducción

actuales, utilizan de forma casi exclusiva el control de la posición a través de las diferencias de amplitud de las ondas detectadas por

el oído. (estereofonía de intensidad) Éste es un proceso sencillo, sin prácticamente ninguna complicación

tecnológica, utilizado masivamente en los procesos de mezcla, tanto en estereofonía como cuadrifonía. Otro asunto muy diferente es

incluir, además de las citadas diferencias de presión sonora, las correspondientes de tiempo y timbre, lo cual, requiere de una tecnología

mucho más elaborada y sofisticada.

Hemos de reconocer que, en la mayoría de ocasiones, no será necesario recurrir a estos procesos adicionales. De hecho, en nuestro

rápido repaso de los sistemas de reproducción electroacústicos convencionales, hablaremos siempre de las diferencias de presión sonora en

los oídos del oyente, dejando de lado otros conceptos relacionados con la localización. Esto sucede así porque en el

estudio de grabación, cuando el técnico ajusta el control panorámico de un canal, está manipulando la diferente

amplitud de la señal en cada uno de los canales estéreo o cuadrafónicos.

No obstante, si lo que pretendemos es obtener un realismo muy cercano a la experiencia sensorial cotidiana, será de gran utilidad aprovechar al

ciento por ciento, todas las posibilidades que el sistema de audición nos ofrece. Uno de estos casos, de gran interés práctico, son

los dispositivos electroacústicos destinados a formar parte de los equipos de Realidad Virtual.

|